ODS con inteligencia

ODS con inteligencia

La IA puede aportar soluciones para llevar a cabo un desarrollo sostenible

Imaginemos que hace unos días me encontraba en un congreso científico. La primera parte del congreso había transcurrido sin mucha novedad en las exposiciones. Correspondía ahora ese café de media mañana que sirve de networking, que no es otra cosa que hablar y relacionarse con otros colegas. Yo removía mi café expreso con la cucharilla, ausente de la conversación en la que me encontraba networkeando, en un movimiento automático y repetitivo.

Desperté a la realidad cuando me enganché, como un oyente intruso, a la conversación de otras dos personas que a mi lado formaban su propio corrillo.

- ¡A ver qué nos cuentan ahora sobre los ODS!

- Espero que sea más interesante que lo escuchado hasta el momento. Sin duda, la inteligencia artificial está ayudando a los ODS.

- No sin riesgos.

- Lo iremos viendo, pero de momento hay grandes esperanzas.

La interlocutora comenzó a relatar todo su conocimiento sobre las iniciativas de inteligencia artificial relacionadas con los ODS.

Buenos objetivos con buena inteligencia artificial

La inteligencia artificial es una herramienta y como tal, podemos usarla para unos fines u otros. Uno de tales fines bien puede, y deben, ser los ODS.

En este sentido, el reconocimiento de imágenes junto con el aprendizaje automático (machine learning) resulta de especial utilidad. Por ejemplo, se ha utilizado para identificar zonas expuestas a altos niveles de pobreza analizando las imágenes por satélite de las regiones en estudio. Mediante el reconocimiento de imágenes se pueden reconocer infraestructuras, tales como carreteras, zonas urbanas, embalses o granjas, y analizar su nivel de construcción y mantenimiento. Esto permite conocer el nivel de desarrollo de cada zona. Por lo general, el acceso a estas zonas es complicado y la información sobre ellas escasa. Este sistema permite analizar grandes zonas de forma eficaz y precisa.

Detrás de estas mismas tecnologías de reconocimiento de imágenes y machine learning se encuentran sistemas que pueden alertar sobre desastres climáticos o bien identificar rápidamente la malnutrición infantil. En este último caso, mediante técnicas de reconocimiento facial se puede analizar en poco tiempo si un niño sufre desnutrición, identificando de forma temprana patrones incipientes causados por la inanición, para así poder poner remedio antes de que sufra las consecuencias de la falta de alimento.

La inteligencia artificial es una herramienta y como tal, podemos usarla para unos fines u otros: por ejemplo, los ODS

No todo es reconocimiento de imágenes. El análisis masivo de datos también ayuda al cumplimiento de los ODS. En Colombia se ha creado un banco genético de semillas de fríjoles, yuca y forraje con el objetivo de poder adaptarlas a posibles cambios climáticos. La iniciativa, que ha recibido una subvención de 17 millones de dólares de la Fundación Bezos para la Tierra, incorpora además técnicas de inteligencia artificial para conocer con antelación el posible crecimiento de las semillas y evitar, entre otras cosas, problemas por falta de biodiversidad en la naturaleza.

Relacionado específicamente con el ODS 3 Salud y Bienestar, la inteligencia artificial se viene utilizando en la investigación de fármacos, ya sea para predecir la toxicidad de los medicamentos, sus propiedades fisicoquímicas o bien generar nuevas medicinas. Con ello se consigue reducir el tiempo de investigación, pasando de años a meses.

- Como ves –concluyó la interlocutora–, muchas posibilidades de la inteligencia artificial para los ODS.

- El problema –respondió su compañero de café– es el uso indebido que se pueda hacer de estas posibilidades.

La cosa de puede torcer

La inteligencia artificial no está exenta de riesgos. Esto no significa dejar de usarla, sino saber cómo usarla. Conducir un vehículo también tiene riesgos y no por ello vamos andando a todos los sitios, sino que conocemos los riesgos y aprendemos a cómo movernos por las ciudades. La Unión Europea es muy consciente de esto posibles riesgos y está elaborando una legislación para regular la inteligencia artificial.

Según su borrador actual, existen ciertos usos de la inteligencia artificial que tienen un riesgo inaceptable, como son la manipulación de las personas, especialmente de grupos vulnerables. Otros usos de la inteligencia artificial se consideran de riesgo alto e incluyen actividades relacionadas con el reconocimiento facial, la gestión de infraestructuras, la educación, el empleo, el control de fronteras o la migración de personas. Estamos hablando de los ámbitos de los ODS.

Los ODS abordan acciones sobre grupos especialmente vulnerables, susceptibles de aceptar cualquier riesgo por un pequeño beneficio. El reconocimiento facial para identificar la malnutrición se puede convertir en clasificación de personas; el análisis de infraestructuras puede servir para el control de la población; la investigación de semillas o de nuevos fármacos puede acabar favoreciendo solo a grupos reducidos, sin garantizar su acceso universal. No digo que vaya a ocurrir, digo que puede ocurrir. Por ello tenemos que estar vigilantes.

La inteligencia artificial no está exenta de riesgos. Esto no significa dejar de usarla, sino saber cómo usarla.

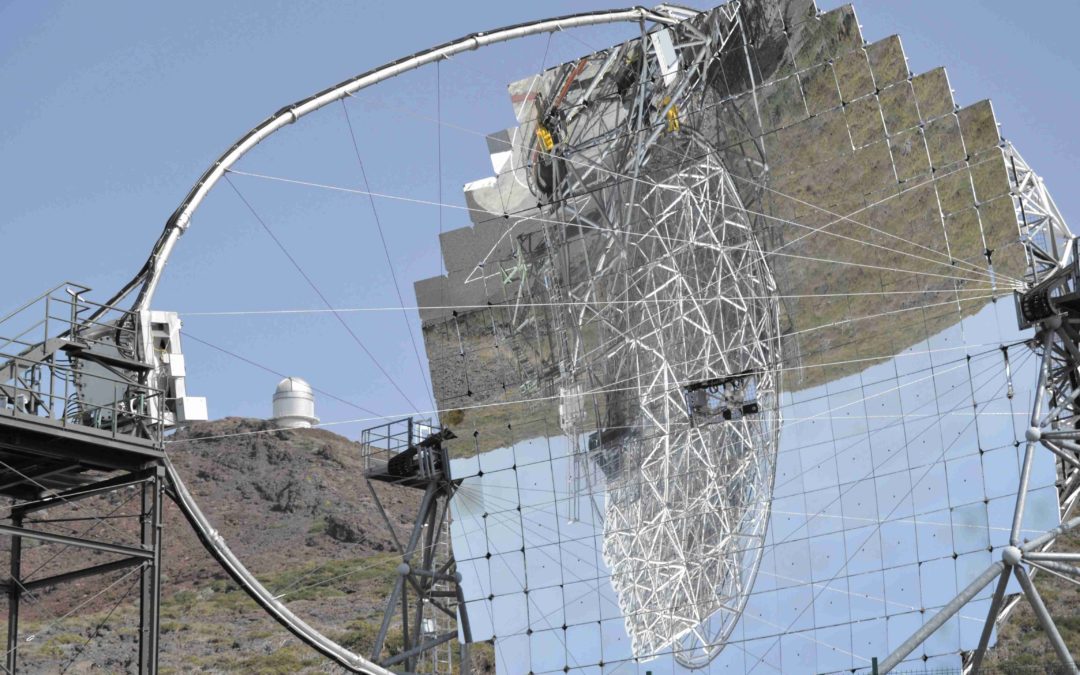

Otro dilema es la huella de carbono que genera la inteligencia artificial. Hemos hablado de sistemas de inteligencia artificial que alertan sobre desastres climáticos, mientras la propia inteligencia artificial genera toneladas de CO2. Se estima que el entrenamiento de GPT3, el modelo de lenguaje detrás de ChatGPT, generó 500 veces más carbono que un solo viajero en un vuelo de ida desde Nueva York a San Francisco. Otra cuestión que resolver y en ello estamos.

- Como ves –concluyó el científico con un gesto de incertidumbre–, luces y sombras…

- Habrá que iluminar las luces.

Estupidez artificial

Los dos científicos se separaron y disolvieron en la masa de asistentes. Inevitablemente me vino a la cabeza la idea de estupidez artificial, que consiste en dejar que la inteligencia artificial decida por nosotros. En pensar que solo existe un camino para la inteligencia artificial y que ese camino excluye o limita al ser humano.

La inteligencia artificial puede ser nuestra aliada o nuestra enemiga para el cumplimiento de los ODS. Depende de nosotros. Para evitar caer en la estupidez artificial aplicada a los ODS, propongo 4 sencillos pasos:

- Analizar las consecuencias, buenas y malas, de una inteligencia artificial para el desarrollo de un objetivo ODS.

- Pensar de qué principios partimos para aplicar una inteligencia artificial. Si queremos buscar, por ejemplo, la equidad o garantizar la autonomía humana.

- Explicar cómo funciona una inteligencia artificial: la forma en la que actúa, sus limitaciones o sus posibles sesgos.

- Por último, y más importante, dejar que la persona decida en qué medida quiere que la inteligencia artificial medie en su vida, por muy loable que sea el objetivo.

Concluyó el café y todos volvimos a la siguiente ponencia, sobre el uso de la inteligencia artificial para el desarrollo de los ODS.

Publicado en El Español