¿Nos hace la IA más desiguales?

¿Nos hace la IA más desiguales?

Si no hacemos nada la IA nos hará más desiguales

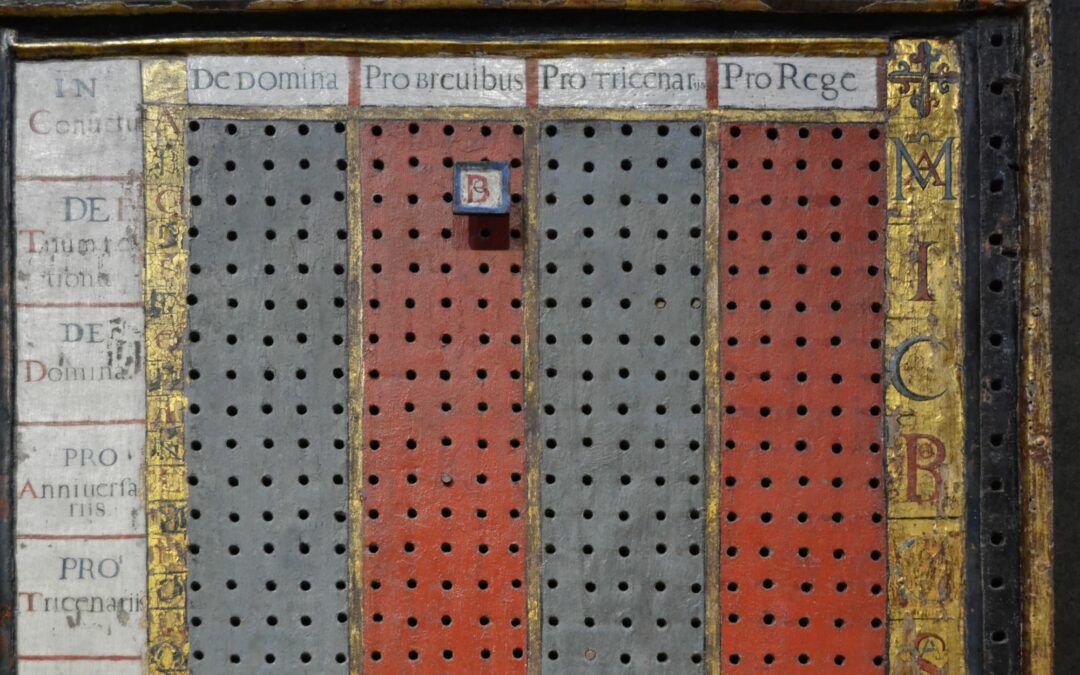

Nada tiene una única causa. Sin embargo, hoy hablamos de inteligencia artificial (IA) porque en el siglo XVII Leibniz tuvo un sueño matemático. El gran filósofo alemán pensó en una máquina ideal, a la cual se le pudiera hacer cualquier tipo de pregunta, luego apretar un botón, y que ésta respondiera atendiendo a una serie de reglas lógicas. A principios del siglo XX se desarrolló formalmente este sueño matemático mediante la formulación del Problema de la Decisión, que planteaba demostrar si existe un algoritmo único que pueda determinar si cualquier proposición es verdadera o falsa. Alan Turing se interesó por el reto y para abordarlo ideó la conocida Máquina de Turing, que es la inspiración de nuestros ordenadores. Demostró que tal algoritmo único no es posible, y a la vez dirigió el camino hacia la IA. Desde los inicios de la IA se encuentra la idea de sustituir al ser humano en su pensamiento. Hoy en día esa sustitución se ve más cercana y se siente como fuente de desigualdad. ¿Nos hace la IA más desiguales?

Matemáticamente desiguales

Si miramos a nuestro alrededor vemos un mundo desigual. Es una apreciación subjetiva, pero la economía, que es la ciencia matemática de la esperanza y la desesperación, nos ofrece una visión cuantitativa de tal apreciación.

Medir la desigualdad es medir el reparto de la riqueza. Para ello se ordena a la población de menor a mayor en la cantidad de riqueza que posee y luego se analiza por ciertos percentiles. Según el World Inequality Report el 50% de la población mundial posee solo el 2% de la riqueza mundial, mientras que hay un 10% superior que posee el 75%, de los cuales un 1% dispone del 38% de tal riqueza. Para el caso de la Unión Europea y los EE. UU., vemos que año tras año el 50% inferior viene perdiendo riqueza, y el 1% superior la va ganando. En nuestra cercanía los pobres son cada vez más pobres y los ricos, más ricos. Así son las matemáticas de la desigualdad.

Esta medición de reparto de la riqueza afecta al ámbito de la persona. Otra visión es la riqueza, o pobreza, de las naciones, que se mide con el indicador de riqueza como porcentaje de la renta nacional. Con datos de 2021 la relación riqueza-renta nacional en España es del 684%. Esto quiere decir que tenemos riqueza para 6,8 años, es decir, España se podría pasar parada, sin producir nada, todo ese periodo de tiempo. Lo relevante de este valor es cómo se reparte ese 684% entre riqueza privada y riqueza pública. En España prácticamente todo ello es riqueza privada, y nada o muy poco es riqueza pública. La misma tendencia aparece de forma global: los países se vuelven ricos, pero sus gobiernos se vuelven pobres. Desigualdad en la relación de fuerzas público-privadas.

Actualmente tiene su esplendor mediático la llamada IA generativa, que es por el momento la mejor aproximación al sueño de Leibniz

Hay desigualdad entre personas y entre lo público y lo privado. Y la tendencia es que esta desigualdad se acentúe. Tener más riqueza significa tener más capacidad de influencia. Quien tiene el capital tiene la capacidad de tomar decisiones sobre cómo utilizar dicho capital (dónde invertir) y sobre qué hacer con los activos que adquiere con dicho capital, como, por ejemplo, con el software de IA.

La inteligencia artificial nos desplaza

Tomando como punto de partida que hay desigualdad, volvamos a la pregunta inicial. ¿Nos hace la IA más desiguales?

La inteligencia artificial consiste en simular algunos de nuestros procesos mentales mediante algoritmos matemáticos. Al hablar del sueño Leibniz, vimos que no existe un único algoritmo que valga para todo, por ello tampoco existe una única IA. Ocurre, por tanto, que existen distintas inteligencias artificiales en la medida en que existen distintas soluciones matemáticas para simular distintos procesos mentales.

Actualmente tiene su esplendor mediático la llamada IA generativa, que es por el momento la mejor aproximación al sueño de Leibniz. La IA generativa asombra porque permite crear textos, imágenes, sonidos o vídeos como respuesta a las peticiones escritas que le hagamos (prompts). Por eso asusta ChatGPT o Dall-E. Porque nos puede reemplazar de forma masiva.

Los actores y guionistas de Hollywood han estado en huelga 148 días para reclamar, entre otras cosas, que la IA generativa sea regulada en el ámbito de su actividad. Tenían razones para ello. Mediante la IA generativa se pueden crear nuevos guiones sin apenas contar con guionista. Puede ser entrenada con voces humanas para generar nuevas voces que luego darán vida a avatares del metaverso. Si prestas tu voz, cobras 150$ la hora. Ganarás un cierto dinero, no mucho, y tu voz natural ya nunca más será necesaria. Apple Book dispone de un servicio para convertir tu novela en audiolibro, sin necesidad de expertos narradores capaces de dar ese giro dramático y emocionante a un párrafo. Ya se encarga de ello su propia IA generativa.

La sustitución del ser humano por la IA no parece ir en favor de la igualdad

Todo esto son pinceladas de un esbozo dramático, que tiene su pintura de gran formato. En mayo IBM anunció su intención de sustituir 7.800 puestos de trabajo por IA. Una gota comparada con los 300 millones de puestos de trabajo que Goldman Sachs estima que pueden ser expuestos por la IA generativa, de los cuales, la cuarta parte como mínimo pueden ser completamente desplazados por la IA generativa. La propia Open IA, dueña de ChatGPT, ha calculado que el 80% de los puestos de trabajo en EE. UU. pueden verse afectados en un 10% por los LLM (Large Language Models), que es la tecnología detrás de ChatGPT.

Menos trabajo, más desigualdad

Detrás de todos estos ejemplos se encuentra el hecho del desplazamiento de la mano de obra por la automatización. En este caso, una automatización que viene de la IA. Esta sustitución del ser humano por la IA no parece ir en favor de la igualdad, porque aumenta el valor del capital y disminuye el valor de trabajo.

Según Daron Acemo?lu la automatización es la causa de la disminución del trabajo y de la bajada de salarios. La base de la riqueza comienza en los salarios, producto del trabajo. Si estos son bajos o no existen, disminuye la riqueza de ese 50% inferior con menos recursos, que solo dispone de su trabajo. Por otro lado, esta automatización hace que el 10% superior con más recursos vea acrecentada su riqueza, pues adquieren más activos en la forma de máquinas, robots o software de IA. Por ello las empresas tecnológicas se valoran tanto en los mercados.

Una forma de ver la relación entre la automatización y la desigualdad es mediante la proporción del PIB generada por el trabajo (labor income share), que determina en qué medida el trabajo aporta al PIB del país. Según la Organización Internacional del Trabajo (OIT), en el periodo de 2004 a 2017 la proporción del trabajo en el PIB ha ido disminuyendo, pasando de un 54% a un 51%. No siempre una disminución de la proporción del trabajo lleva a aumentar la desigualdad, pero sí se ve esta relación en los países con economías más desarrolladas, como EE. UU o la UE. Todo parte de la bajada del coste de la tecnología. Si disponemos de una tecnología de bajo coste, sale rentable desplazar el trabajo en favor de la automatización, disminuyendo la proporción del trabajo y aumentando la desigualdad. Esa tecnología de bajo coste bien puede ser la IA.

Menos impacto, más trabajo

Pero nada tiene una única causa y en el caso de la desigualdad este hecho es más patente. No existe un consenso sobre las causas de esta desigualdad o al menos en qué medida afecta cada causa. No todo el mundo está de acuerdo en que la automatización sea la causa de la disminución del trabajo. Para la consultora estratégica McKinsey la principal causa de disminución del trabajo en la aportación al PIB viene de los superciclos de subida y bajada de precios, como, por ejemplo, los vividos recientemente en el sector de energía eléctrica. La automatización solo afecta en un cuarto lugar.

Si no hacemos nada, es muy posible que la fuerza de la riqueza nos lleve a una mayor desigualdad de la mano de la IA

Tampoco existe consenso sobre si la IA generativa va a destruir o generar empleo. Recientemente la OIT ha emitido un informe en el que estima que la IA generativa va a tener un mayor impacto en el aumento del trabajo que en la automatización. Según sus estimaciones, el aumento del trabajo afectaría a unos 427 millones de puestos de trabajo, mientras que la automatización a unos 75 millones, siendo los más afectados aquellos con labores administrativas. Calcula, además, que este impacto va a ser incluso más significativo en las economías más ricas.

No cabe, pues, lugar a la desesperanza. La IA no nos va a desplazar. Quizás seguiremos siendo desiguales, pero, según estos informes, no será por causa de la IA.

Olvidemos el Test de Turing

¿Nos hace la IA más desiguales? Hay distintas visiones. Antes de esperar cuál de ellas acierta, al menos todas presentan un consenso. Si no hacemos nada, es muy posible que la fuerza de la riqueza nos lleve a una mayor desigualdad de la mano de la IA. Debemos actuar.

Joseph Stiglitz, Premio de Economía del Banco de Suecia (asimilado como Nobel de Economía), aboga por aumentar la demanda agregada, favoreciendo la creación de empleo y sin perder productividad, y disponer de políticas que permitan capacitar a las personas en la IA. Cabe decir que la reciente orden ejecutiva emitida por la Casa Blanca contempla acciones en favor de esa protección del trabajo. Yendo más lejos, para aumentar la demanda, Stiglitz defiende incluso pasar a una semana de 35 horas laborables, partiendo de la premisa de que no todo es medir el PIB, sino también el bienestar.

Para conseguir esta demanda de trabajo es necesario un cambio de mentalidad. Pensar más en cómo utilizar la IA para aumentar las capacidades del ser humano, en lugar de imitarlo. Con ello se crearán nuevas capacidades, nuevos productos y servicios, generando así mucho más valor que la mera sustitución del trabajador por la IA. Es lo que Erik Brynjolfsson llama salir de la trampa de Turing.

Alan Turing ideó su famoso Test de Turing para verificar si una máquina pensaba. Era la materialización del sueño de Leibniz. Esta idea nos ha llevado a pensar en una IA que sea igual a nosotros, en lugar aquella otra IA que pueda complementar nuestras capacidades. En realidad, Leibniz pensó en su máquina ideal para ayudar a los sabios a pensar, no para sustituirlos. La IA no nos hará desiguales si pensamos en ella como potencial para crear nuevas oportunidades. La mayor fuente de desigualdad viene de igualar al ser humano con la máquina

Publicado en Esglobal